Adam: A Method for Stochastic Optimization

April 9, 2022ADAMはAdaptive moment estimationに由来し、名前のとおり、推定した1, 2次のモーメントによる学習率最適化のアルゴリズムである。 勾配が疎なときに有効なAdaGradの利点と、目的関数が時間とともに変化してもよいRMSPropの利点をそなえる。 一次や二次のモーメントを、指数関数的に加重を減少させる移動平均で推定する。 ただし、モーメントの初期値を0にすると最初のうちはモーメントの推定値が0に偏ってしまう。 そこで、反復回数がすくないほど推定値を大きくなるよう補正する。

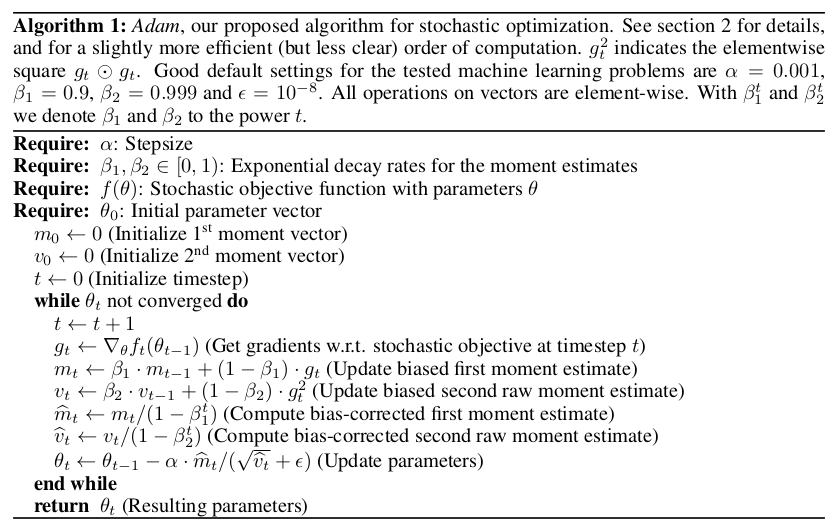

アルゴリズムを以下に示す。

一次と二次のモーメントを反復回数にしたがって大きくなる\((1-\beta_{1,2}^t)\)で除算し、推定値を補正している。

論文をこちらからダウンロードできます。

画像は論文から引用されています。