論文メモ Google's Neural Machine Transltation System: Bridging the Gap between Human and Machine Translation

May 30, 2020概要

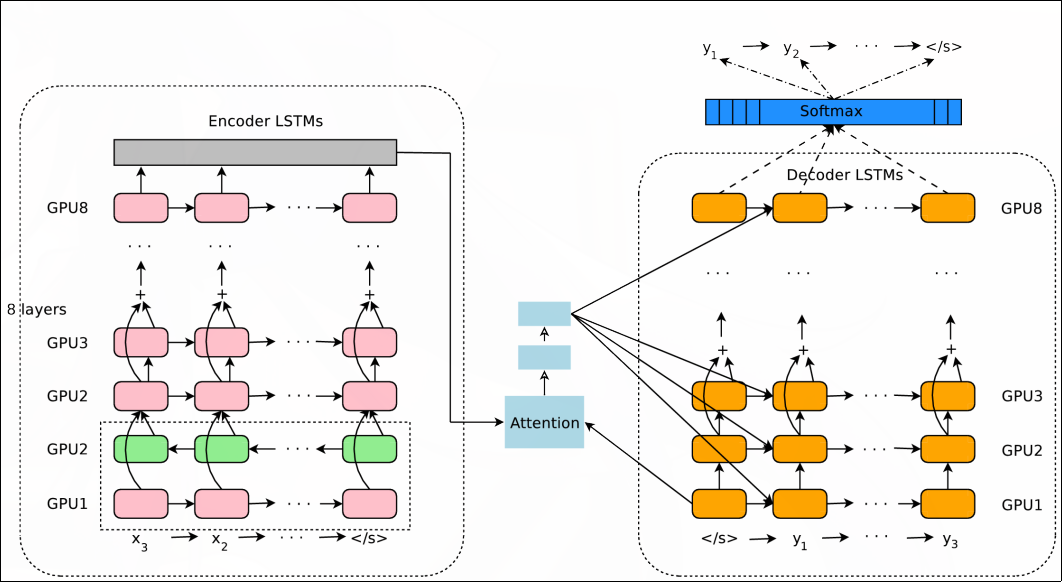

ニューラルネットワークをもちいた機械翻訳システムの論文である。 解決したい問題として、学習と推論時の処理時間の長さ、低頻出の単語を翻訳する難しさ、入力文の一部が翻訳されないことをあげ、注意機構でつながれたEncoderとDecoderからなるアーキテクチャを提案した。 学習時間を短縮するために、Decoderの最初の層とEncodeerの出力層から注意をつくる注意機構を採用し、Decoderを並列に学習できるようにしている。 また、量子化によって推論時間を短縮をしている。 低頻出の単語でも翻訳できるようにwordpieceでエンコードされた入力をうけとる。 入力文の一部が翻訳されない問題に対しては、短い出力文に罰則を課すビームサーチで出力文の候補を探索する仕組みが導入されている。

アーキテクチャ

アーキテクチャのEncoderとDecoderは、それぞれ8層のLSTMからなり、アーキテクチの様子を以下の図のとおりである。

Encoderの1層目のみが双方向LSTMであり、ほかは単方向のLSTMがもちいられてる。

また、勾配爆発、消失問題を防ぐために、Residual connectionを導入し、前の層の入力と出力をたした値が次の層に渡している。

- 論文はこちらからダウンロードできます。

- 図はすべて論文から引用されています。