論文メモ Model-Agnostic Meta-Learning for Fast Adaptation of Deep Networks

September 18, 2020表題の略称MAMLで知られるメタ学習であり、少ない教師データで新しいタスクに対応することを目的としている。 Model-Agnosticとあるように、MAMLの汎用性は高く、勾配法をもちいるモデルであえば適用可能である。 論文には、教師あり学習だけでなく強化学習の事例もある。 さまざまなタスクに適した初期パラメタを見つけ、データ件数の削減をねらう。 目的のパラメタを求めるためには、複数のタスクを用意し、これらの損失関数の合計値を最小にするように勾配法でパラメタの更新を繰り返す。 最後に更新されたパラメタをモデルの初期値に設定する。

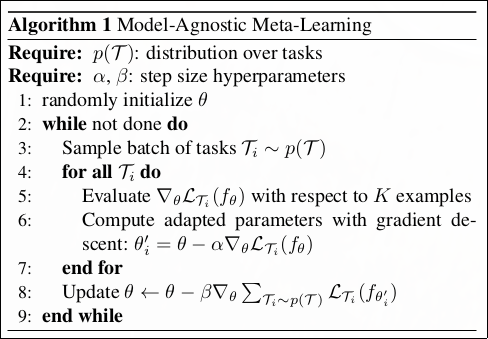

以下に示したMAMLのアルゴリズムは、入力に、学習率\(\alpha\), \(\beta\)とタスクの分布\(p(\tau)\)を求める。 タスク\(\tau\)は、\(\mathcal{L}\)を損失関数、\(\mathrm{\boldsymbol{x}}\)を観測値、\(\mathrm{\boldsymbol{a}}\)をラベルとして次の式で表される。 \(\mathrm{\boldsymbol{x}}\)が独立同一分布に従わなくてもよい。 教師あり学習で、独立同一分布に従うならば、\(H=1\)となる。 適用例としては、主クラス数\(N\)の多クラス分類について、各クラスごとに\(K\)件の事例を用意し、MAMLを適用することで、未知のクラスに少量の教師データで適用にできるように学習するケースが考えられる。

$$ \tau = \\{\mathcal{L}(\mathrm{\boldsymbol{x}}\_1,\mathrm{\boldsymbol{a}}\_1, \dots ,\mathrm{\boldsymbol{x}}\_{H},\mathrm{\boldsymbol{a}}\_{H}),q(\mathrm{\boldsymbol{x}}\_1),q(\mathrm{\boldsymbol{x}}\_{t+1}\mid \boldsymbol{\mathrm{x}}\_t,\boldsymbol{\mathrm{a}}\_t),H\\} $$

論文をこちらからダウンロードできます。