Playing Atari with Deep Reinforcement Learning(2013)

February 9, 2020概要

深層強化学習をAtari2600の7つのゲームに応用し、うち6つについて先行手法の性能を超えたDeep Q-Networks(DQN)を提案した論文である。 ピクセルデータを直接入力として与え、深層学習で方策を学習する手法としては初めて提案された。

アルゴリズム

DQNは、Q関数の関数近似噐に畳み込みニューラルネットワーク(CNN)を使う適合Q反復法である。

環境\(\epsilon\)を推定しないモデルフリー型で、環境の相互作用から得た大量のデータから方策を学習するバッチ学習に分類される。

確率的勾配降下法によりモデルの重みを更新する。

ただし、時間ステップの近い経験データ間には強い相関があるが、SGDは経験をiidに観測できていることを想定している。

そこで、経験データを一様に乱択する経験再生で選ばれた経験データで重みを更新する。

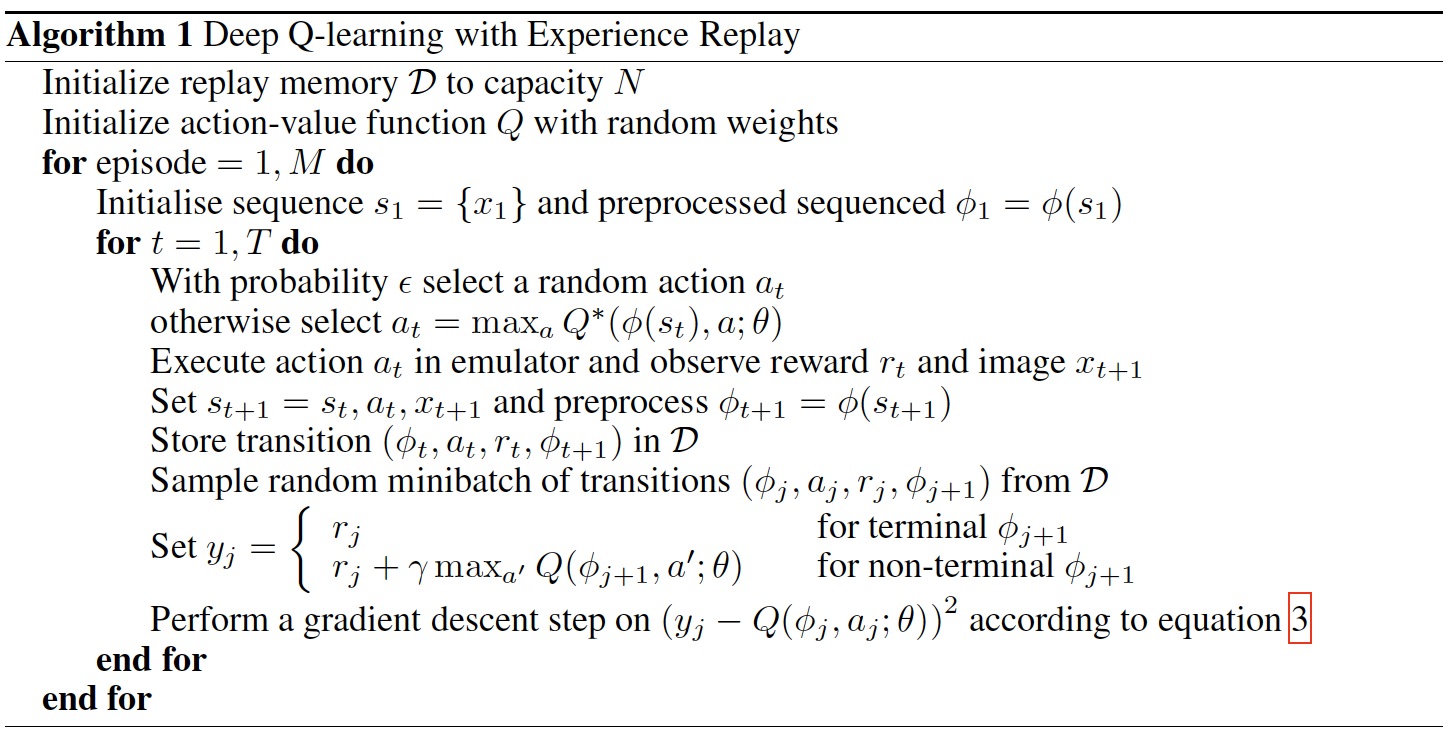

DQNのアルゴリズムを以下に示す。方策モデルには、\(\epsilon\)貪欲方策が採用されている。

ただし、\(x_i\)は画面のイメージ、CNNに入力するために可変長の履歴データを固定長に変換する関数を\(\phi\)とする。

図の方程式3は、ベルマン方程式のQ関数を重みを\(\theta\)とする関数近似噐\(Q(s,a;\theta_i)\)で近似したときの損失関数\(L_i(\theta_i)\)を

図の方程式3は、ベルマン方程式のQ関数を重みを\(\theta\)とする関数近似噐\(Q(s,a;\theta_i)\)で近似したときの損失関数\(L_i(\theta_i)\)を

としたときの勾配\(\nabla_{\theta_i}L_i(\theta_i)\)

$$ \nabla\_{\theta\_i}L\_i(\theta\_i) = \mathbb{E}\_{s,a\sim \rho(\cdot);s'\sim\epsilon}[\left(r+\gamma\max\_{a'}Q(s', a';\theta\_{i-1})-Q(s,a;\theta\_i)\right)\nabla\_{\theta}Q(s,a;\theta\_i)] $$である。\(\rho(s, a)\)は状態\(s\)と行動\(a\)の確率分布である。

- 論文をこちらからダウンロードできます。

- 画像はすべて論文から引用されています。